Il 29 settembre 2023 Andrea Fontana (@twittatore) posta il seguente quesito sul social che tutti chiamano ancora Twitter, benché il suo proprietario si ostini a pretendere che si chiami X. Il post è interessante perché permette di far vedere come la fisica Newtoniana sia tutto fuorché intuitiva, con buona pace di quelli che dicono che… Continua a leggere Il dito di Archimede

La divulgazione scientifica

Il 19 marzo 2023 sono stato invitato a dire la mia su Twitter a proposito di un post su "Math is in the air" (che, a proposito, vale la pena di seguire se non lo fate già). Il titolo del post è: "Opinioni impopolari sulla divulgazione scientifica: i video in stile tik tok avrebbero anche… Continua a leggere La divulgazione scientifica

La guerra in Ucraina

Il mio corso di Laboratorio di Fisica è iniziato proprio nei giorni in cui la Russia ha invaso l'Ucraìna e il rumore della guerra si ode di nuovo alle porte dell'Europa. È probabile che qualcuno si stia chiedendo che senso ha parlare di misure, unità, grandezze fisiche (ma anche, altrove, di arte, letteratura, musica, etc.)… Continua a leggere La guerra in Ucraina

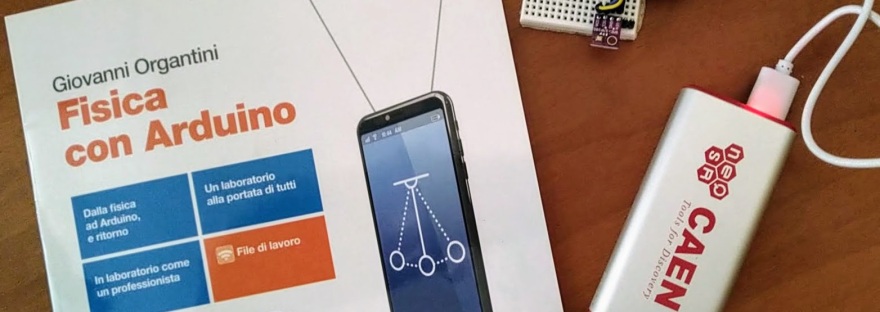

The Best New Smartphone Book

I am very proud to announce that my book, "Physics Experiments with Arduino and Smartphones", published by Springer, has been awarded as the Best New Smartphone Books by BookAuthority.org, as announced in late 2021. BookAuthority collects and ranks the best books in the world, and it is a great honour to get this kind of… Continua a leggere The Best New Smartphone Book

La scuola di Bedonia

Dal 6 all'8 settembre 2021 si è svolta una nuova edizione della Scuola di Fisica con Arduino, questa volta in versione residenziale, con tutor e partecipanti ospitati dal Seminario Vescovile di Bedonia. La scuola è stata organizzata dall'Università di Parma sotto la direzione della Prof.ssa Maura Pavesi. Le attività si sono svolte nel modo classico:… Continua a leggere La scuola di Bedonia

Suggerimenti per un kit Arduino progressivo

Molti mi chiedono se sia meglio comprare un kit completo o solo pochi componenti, per iniziare a usare Arduino, specie in ambito scolastico o educativo in generale. Ho quindi predisposto questo documento, nel quale i componenti da acquistare sono divisi in gruppi, con l'idea che si possano fare alcuni esperimenti con il primo blocco, integrando… Continua a leggere Suggerimenti per un kit Arduino progressivo

Uno studio sperimentale della fisica dei gas

In uno dei miei ultimi post, mostro come ottenere dati sperimentali da Arduino tramite BLE. Come promesso, discuto ora la raccolta e l'interpretazione di questi dati, nel caso di un esperimento in cui un gas è soggetto a una trasformazione isòcora: un processo in cui la pressione p e la temperatura T possono cambiare, mentre… Continua a leggere Uno studio sperimentale della fisica dei gas

La divulgazione scientifica secondo me

Nel mio ultimo post ho fatto alcune considerazioni di natura statistica sulla vicenda che ha indotto le agenzie regolatorie europee a sospendere la somministrazione del vaccino AstraZeneca. Prima che arrivi qualche commento negativo, voglio dire subito che sono perfettamente cosciente del fatto che la mia analisi è molto grossolana e che taluni la definirebbero anche… Continua a leggere La divulgazione scientifica secondo me

Il caso AstraZeneca

Da qualche giorno è in corso un'isterica reazione alle "notizie" secondo le quali si sarebbero verificate alcune morti "sospette" dopo l'inoculazione del vaccino AstraZeneca. L'allarme, va detto, è stato amplificato da molti quotidiani che hanno esposto titoli più che fuorvianti. Finora, devo riconoscerlo, l'unico quotidiano che ha prodotto notizie degne di questo nome a me… Continua a leggere Il caso AstraZeneca

BLE con Arduino

In questo post illustro il funzionamento (non proprio banale) di un Arduino con BLE (Bluetooth Low Energy). Come al solito, essendo la fisica il mio campo, non discuterò un esempio generico (l'equivalente di "Hello, World!"), ma una concreta applicazione di fisica, con tanto di discussione dei risultati. In certi passaggi, per brevità o per chiarezza,… Continua a leggere BLE con Arduino